Auf dem SEACAMP in Jena habe ich am 8. Mai 2025 einen umfassenden Vortrag über SEA Reporting Dashboards gehalten. Für alle, die nicht dabei sein konnten oder das Wissen nochmals vertiefen möchten, fasse ich hier die wichtigsten Inhalte und detaillierte Praxisbeispiele zusammen.

Warum professionelle Dashboards?

Agenturdashboards schaffen einen einheitlichen Kommunikationsstandard, ermöglichen eine tagesaktuelle Leistungsanalyse und erleichtern die Kommunikation gegenüber Kunden erheblich. Individuelle Filter, zentrale Datenquellen und eine visuell verständliche Darstellung eliminieren das Excel-Chaos und stärken den professionellen Auftritt.

Anforderungen an ein optimales Dashboard

Ein gutes Dashboard sollte folgende Kriterien erfüllen:

- Einheitlichkeit über Kunden hinweg

- Schnelle Orientierung für SEA Manager

- Rasche Erstellung und Skalierbarkeit

- Wartung und Bedienung durch mehrere Personen

- Kontrollierter Datenumfang und schnelle Ladezeiten

- Integration spezifischer Business Cases und eigenes Branding

Looker Studio für schnelle, flexible Dashboards

Looker Studio (ehemals Data Studio) ist Googles kostenloses BI-Tool zur Visualisierung von Daten. Für SEA-Manager bietet es eine unkomplizierte Möglichkeit, Reportings zu erstellen – besonders in Kombination mit Google-Datenquellen wie Google Ads, GA4 oder BigQuery.

Vorteile:

- Kostenfrei: Ideal für Agenturen mit vielen Kunden.

- Direkte Integration: Nahtloser Zugriff auf GA4, Google Ads, Google Sheets, BigQuery uvm.

- Interaktiv: Nutzer können Zeiträume flexibel wählen, per Klick filtern und die Datenaufbereitung direkt steuern.

- Visualisierung: Viele verschiedene Diagrammtypen, Tabellen, Balken und Metrik-Kacheln.

Nachteile:

- Performance: Bei größeren Datenmengen (z. B. >1 Mio. Zeilen) wird das Dashboard langsam.

- Abhängigkeit vom Google Account: Nutzer benötigen zwingend einen Google-Login zur Nutzung und Ansicht.

- Limitierte Kombinierbarkeit: Nicht alle Datenfelder lassen sich beliebig kombinieren.

- Ad-hoc-Verbindungen: Datenabrufe können bei nicht voraggregierten Quellen langsam oder instabil sein.

- Kein eigener Speicher: Die Daten liegen nicht im Looker Studio selbst, sondern in den verknüpften Quellen – was zu Latenzen führen kann.

Looker Studio ist ideal für einfache, schnelle Dashboards mit Google-Bezug. Für größere Setups empfiehlt sich die Kombination mit BigQuery als vorgelagerte Datenbasis und strukturierte Vorverarbeitung über Tools wie Dataform.

- Looker Studio ermöglicht flexible, kostenfreie Dashboards mit:

- Zeitraumwahl

- Direkter Filterung durch Klicks auf Werte

- Vielfältigen Visualisierungen

- Direkter Integration vieler Quellen (GA4, Google Ads, BigQuery, Google Sheets)

Allerdings stößt Looker Studio bei größeren Datenmengen an Grenzen und benötigt zwingend ein Google-Konto.

Skalierung mit Google BigQuery

Google BigQuery ist das Herzstück eines skalierbaren Agenturdashboards. Als performantes, cloudbasiertes Data Warehouse eignet es sich ideal für die zentrale Verwaltung großer und komplexer Datenmengen.

Vorteile:

- Skalierbarkeit: Verarbeitung von Milliarden Zeilen bei hoher Geschwindigkeit.

- Zentrale Datenhaltung: Alle Kunden- und Kampagnendaten liegen an einem Ort.

- SQL-Abfragen: Nutzung eines leistungsfähigen SQL-Dialekts für individuelle Analysen.

- Automatisierung: In Kombination mit Tools wie Dataform und Terraform lassen sich Datenflüsse automatisieren.

- Sicherheit & Rechtevergabe: Feingranulare Zugriffskontrolle über Google Cloud IAM.

Nachteile:

- Kosten: Abrechnung nach Abfragevolumen (bei schlechter Abfrageoptimierung potenziell teuer).

- Komplexität: Höhere Einstiegshürde für Teams ohne SQL- oder Cloud-Erfahrung.

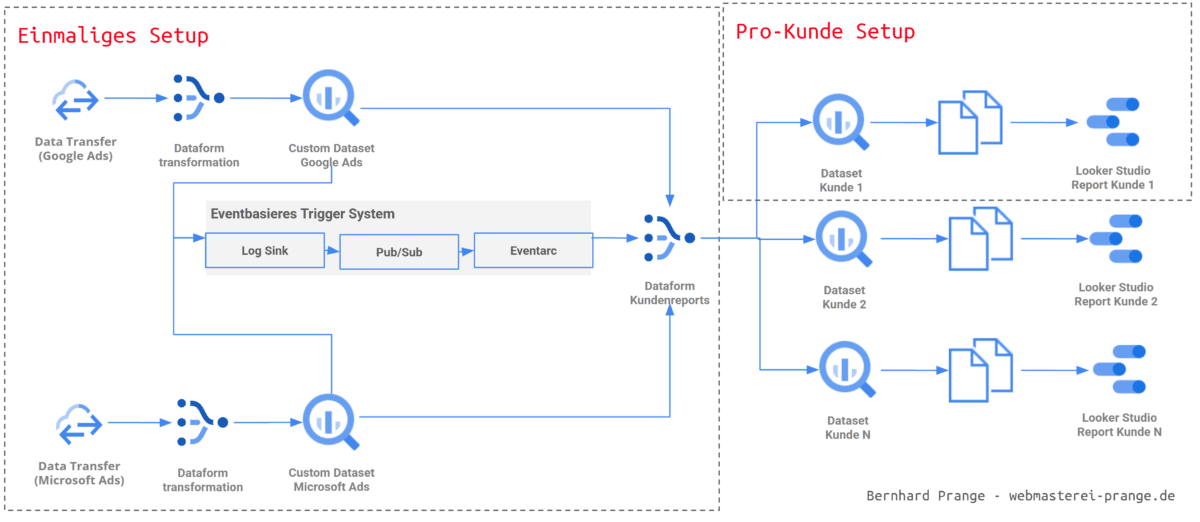

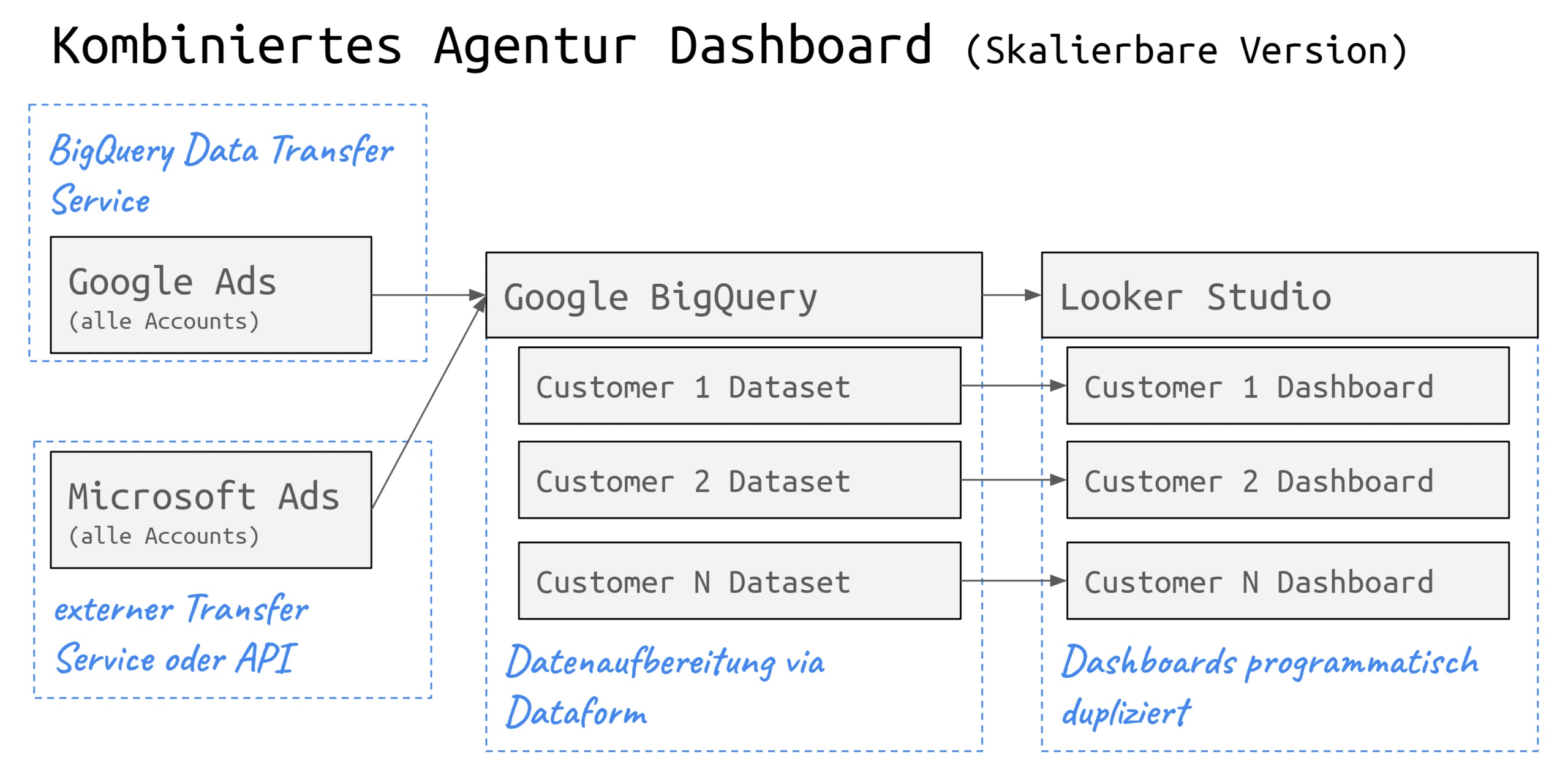

Beispiel: Kombiniertes Agentur Dashboard (skalierbare Version)

Die Architektur eines skalierbaren Dashboards basiert auf folgendem Aufbau:

- Datenquellen: Google Ads & Microsoft Ads (jeweils alle Accounts)

- Import: Per Data Transfer Services nach Google BigQuery

- Struktur: Pro Kunde ein eigenes Dataset

- Transformation: Datenaufbereitung über Dataform

- Visualisierung: Dashboards pro Kunde in Looker Studio

Dieser Aufbau erlaubt:

- Kundenindividuelle Filter und Visualisierungen

- Gleichbleibende Struktur und Logik pro Dashboard

- Zentrale Pflege und Skalierung neuer Kunden

- Versionskontrolle über SQL- und Terraform-Projekte

BigQuery macht es möglich, sowohl operative Kennzahlen (z. B. Klicks, Conversions) als auch strategische Analysen (z. B. Kanalvergleiche, Langzeitauswertungen) auf einem einheitlichen Datenlayer abzubilden. Google BigQuery löst diese Probleme und dient als zentrales Data Warehouse:

- Schnelle Integration diverser Datenquellen

- Nutzung eines SQL-Dialekts

- Einfache Automatisierung und Reproduzierbarkeit

BigQuery Data-Transfer Service (DTS)

Ein zentrales Element zur effizienten Integration von Marketingdaten in BigQuery ist der BigQuery Data Transfer Service (DTS). Dieses Tool ermöglicht es, Daten aus Quellen wie Google Ads oder dem Merchant Center automatisch und regelmäßig zu importieren.

Vorteile:

- Automatisierte Datenimporte: Kein manueller CSV-Export oder API-Scripting nötig

- Nahtlose Integration mit Google-Produkten: Daten aus Google Ads oder Google Analytics können mit wenigen Klicks eingebunden werden

- Zeitgesteuerte Abläufe: Tägliche oder stündliche Datenaktualisierung möglich

- Kombinierbar mit Drittanbietern: Über Connectoren wie Supermetrics oder winsor.ai lassen sich auch externe Plattformen anbinden

Nachteile:

- Veraltete API-Versionen: Einige Connectoren verwenden nicht immer die neuesten API-Versionen, was zu fehlenden Feldern führen kann

- Begrenzte Kontrolle: Der Transfer-Prozess ist weniger flexibel als bei einer individuell entwickelten API-Integration

- Kostenfaktor bei Drittanbieter-Connectoren: Supermetrics & Co. verursachen zusätzliche Lizenzgebühren

Beispielhafte Anwendung:

Gerade bei der Erstellung von Agenturdashboards ist DTS nützlich, um regelmäßig Google Ads-Daten für alle Kunden in BigQuery bereitzustellen. Diese Datasets können anschließend mit Dataform weiterverarbeitet und durch Looker Studio visualisiert werden. Damit ist der Grundstein für ein skalierbares, automatisiertes Reporting gelegt.

Konfiguration Google Ads Data Transfer

Um den Google Ads Data Transfer in BigQuery zu aktivieren, ist keine eigene API-Programmierung notwendig. Die Aktivierung erfolgt direkt über die Google Cloud Console:

- BigQuery Projekt wählen – Stelle sicher, dass das Projekt über Abrechnung verfügt und BigQuery aktiviert ist.

- Data Transfer Service aufrufen – Unter „Transfers“ in BigQuery kannst du einen neuen Transfer erstellen.

- Datenquelle wählen – Wähle z. B. „Google Ads“ als Quelle.

- Konto verknüpfen – Der Google Ads Account muss über OAuth authentifiziert werden.

- Transfer konfigurieren – Lege Ziel-Dataset, Aktualisierungsintervall und Startdatum fest.

Nach dem Setup erstellt BigQuery automatisch tabellarische Datenstrukturen wie Customer, Campaign, AdGroup, Ad etc. Diese Tabellen sind die Basis für die weitere Verarbeitung mit SQL-Tools wie Dataform. Zu beachten ist, dass nicht alle Metriken oder Zuordnungen enthalten sind – etwa fehlen häufig die Namen der Kampagnen oder Accounts, sodass zusätzliche Join-Logik (z. B. über customer_id und campaign_id) nötig wird.

Erweiterte Konfigurationsoptionen im BigQuery Data Transfer Service

Der BigQuery Data Transfer Service (DTS) bietet zusätzliche Konfigurationsmöglichkeiten, um den Datenimport aus Google Ads präziser zu steuern.

Table Filter: Mit dieser Option können spezifische Tabellen für den Import ausgewählt oder ausgeschlossen werden. Standardmäßig werden alle verfügbaren Tabellen importiert. Durch die Angabe von Tabellennamen (z. B. Campaign, AdGroup) oder das Voranstellen eines Minuszeichens zur Exklusion (z. B. -Campaign, AdGroup) lässt sich der Import gezielt steuern. (Quelle: Google Cloud)

Aktualisierungsfenster (Refresh Window): Dieses Fenster bestimmt, wie viele Tage rückwirkend Daten bei jedem Transfer aktualisiert werden. Standardmäßig beträgt das Aktualisierungsfenster 7 Tage, kann jedoch auf bis zu 30 Tage erweitert werden. Dies ist besonders nützlich, um verspätete Datenaktualisierungen zu erfassen oder Datenlücken zu schließen. (Quellen: Stack Overflow, Supermetrics Support)

Benutzerdefinierte Berichte: Für spezifische Analysebedürfnisse können benutzerdefinierte Berichte mittels Google Ads Query Language (GAQL) erstellt werden. Dabei wird für jeden benutzerdefinierten Bericht eine GAQL-Abfrage definiert, die die gewünschten Felder und Ressourcen spezifiziert. Es ist wichtig zu beachten, dass bestimmte GAQL-Klauseln wie WHERE, ORDER BY, LIMIT und PARAMETERS im Kontext des DTS nicht unterstützt werden. Zudem wird automatisch eine Bedingung WHERE segments.date = run_date hinzugefügt, wenn ein Datumssegment in der Abfrage enthalten ist. (Quellen: Google Cloud, Swipe Insight, Stack Overflow)

Durch die Nutzung dieser erweiterten Konfigurationsoptionen können Datenimporte aus Google Ads effizienter und zielgerichteter gestaltet werden, was die Qualität und Relevanz der in BigQuery verfügbaren Daten verbessert.

Automatisierung der Datenübertragung mit Dataform

Dataform ist ein Open-Source-Tool von Google, das speziell für die Orchestrierung von SQL-basierten Transformationen in Data Warehouses wie BigQuery entwickelt wurde. Es erlaubt Teams, SQL-Code strukturiert zu organisieren, modular zu entwickeln und über Git zu versionieren. Dataform ist besonders stark in Projekten, bei denen viele wiederkehrende Transformationen konsistent und reproduzierbar ausgeführt werden müssen.

Vorteile von Dataform:

- SQL-first: Keine zusätzliche Programmiersprache notwendig – alle Transformationen basieren auf SQL.

- Inkrementelle Verarbeitung: Tabellen können effizient aktualisiert werden, ohne komplette Neuberechnungen.

- Abhängigkeitsmanagement: Dataform erkennt automatisch, in welcher Reihenfolge Tabellen erstellt werden müssen.

- Automatisierung: Jobs lassen sich über Zeitpläne oder Trigger automatisch ausführen.

- Git-Integration: Änderungen am Code sind nachvollziehbar, testbar und teamfähig.

Konkrete Verwendung in Dashboard-Projekten:

In SEA-Dashboards wird Dataform genutzt, um die aus dem BigQuery Data Transfer Service importierten Rohdaten aufzubereiten:

- Umwandlung von Rohtabellen in nutzbare Modelle (z. B. Kampagnenreport, Tagesmetriken, Kanalzusammenfassungen)

- Joinen von Tabellen, um fehlende Felder wie Kampagnen- oder Accountnamen zu ergänzen

- Berechnung benutzerdefinierter KPIs, etwa Kosten/Umsatz-Verhältnisse oder TV-Attributionen

- Bereitstellung finaler Reporting-Tabellen als Quelle für Looker Studio

Beispiel Dataform SQL-Definition:

config {

type: "table",

schema: "reporting",

name: "daily_campaign_performance",

tags: ["google_ads"]

}

SELECT

campaign_id,

customer_id,

DATE AS report_date,

clicks,

impressions,

cost_micros / 1e6 AS cost_eur

FROM

raw_google_ads_campaign_stats

WHERE

DATE >= CURRENT_DATE() - INTERVAL 30 DAY;

Dashboard-Erstellung in wenigen Minuten mit Looker Studio Dashboard Cloner

Der Looker Studio Dashboard Cloner (lsd-cloner) ist ein Open-Source-Tool von Google, das die effiziente Duplizierung von Looker Studio Dashboards ermöglicht. Es nutzt die Looker Studio Linking API, um Dashboards inklusive ihrer Datenquellen zu kopieren und dabei spezifische Anpassungen vorzunehmen.

Funktionen und Einsatzmöglichkeiten

- Interaktive Konfiguration: lsd-cloner führt den Benutzer durch eine Reihe von Fragen, um die gewünschten Anpassungen für das zu klonende Dashboard festzulegen.

- Automatisierte Link-Erstellung: Basierend auf den Eingaben generiert das Tool einen Link, der beim Öffnen das Dashboard mit den angegebenen Einstellungen kopiert.

- Anpassung von Datenquellen: Es ermöglicht die Neuzuordnung von Datenquellen, sodass das geklonte Dashboard auf andere BigQuery-Tabellen oder -Views verweist.

- Vorlagenbasiertes Arbeiten: Durch die Verwendung von JSON-Konfigurationsdateien können wiederkehrende Klonvorgänge standardisiert und automatisiert werden.

- Batch-Verarbeitung: Es lassen sich mehrere Dashboards in Serie generieren – ideal bei größerer Mandantenanzahl.

- CLI-basiert: Läuft auf der Kommandozeile, lässt sich leicht in CI/CD-Prozesse integrieren.

Beispielhafte Anwendung

Ein typisches Szenario ist die Erstellung von kundenindividuellen Dashboards basierend auf einer zentralen Vorlage. Durch die Anpassung der Datenquellen und anderer spezifischer Parameter können maßgeschneiderte Dashboards für verschiedene Kunden oder Projekte schnell und konsistent erstellt werden.

Beispielhafte JSON-Konfiguration

{

"project_id": "webmasterei-reports",

"dashboard_id": "456789-d764-4847-ba1a-99d8153a8793",

"dashboard_name": "{company name} Ads-Dashboard",

"dashboard_dataset": "report_companyname",

"dashboard_datasources": {

"campaigns": "campaigns"

}

}

Kommandozeilenbefehl zur Nutzung

npm install -g lsd-cloner lsd-cloner --answers=lookerstudio-ecommerce.json

Dieses Vorgehen ermöglicht eine effiziente Skalierung von Reporting-Dashboards und stellt sicher, dass alle Dashboards auf dem neuesten Stand und konsistent mit den aktuellen Datenquellen bleiben.

Hinweis: lsd-cloner ist ein inoffizielles Tool und wird nicht offiziell von Google unterstützt. Es empfiehlt sich, vor dem Einsatz in produktiven Umgebungen entsprechende Tests durchzuführen.

GitHub-Link: https://github.com/google/looker-studio-dashboard-cloner

Terraform ist ein Open-Source-Infrastrukturmanagement-Tool von HashiCorp, das es ermöglicht, Cloud-Ressourcen deklarativ über Code zu verwalten. Im Gegensatz zu einer manuellen Konfiguration über Benutzeroberflächen erlaubt Terraform die Definition der gesamten Infrastruktur in Konfigurationsdateien – was Wartung, Wiederholbarkeit und Skalierung enorm erleichtert.

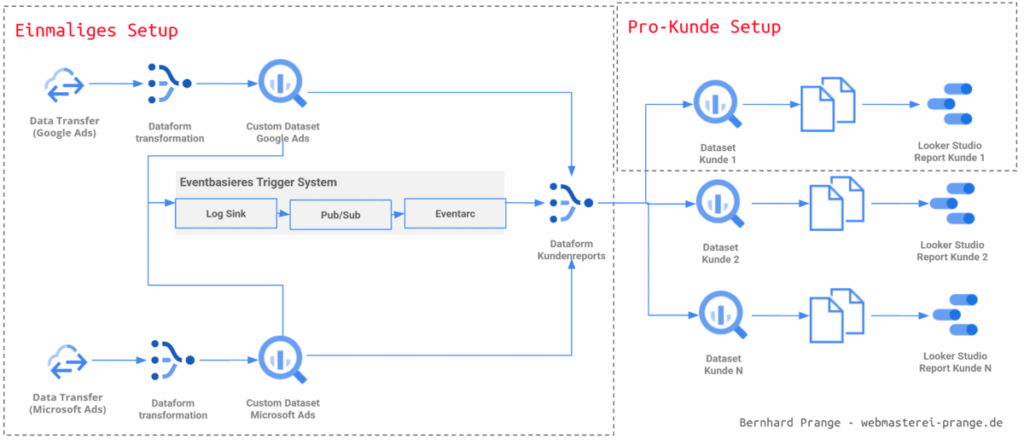

Komplexer Aufbau der Google Cloud

Anhand des Bildes lässt sich erkennen, wie komplex der Aufbau in der Google Cloud seien kann um das gewünschte Setup zu erreichen. Dadurch wird das Setup fehleranfällig und schwer nachvollziehbar. Einen Ausweg bietet hier Terraform.

Infrastrukturmanagement mit Terraform

Terraform ist ein Open-Source-Infrastrukturmanagement-Tool von HashiCorp, das es ermöglicht, Cloud-Ressourcen deklarativ über Code zu verwalten. Im Gegensatz zu einer manuellen Konfiguration über Benutzeroberflächen erlaubt Terraform die Definition der gesamten Infrastruktur in Konfigurationsdateien – was Wartung, Wiederholbarkeit und Skalierung enorm erleichtert.

Anwendung im Google Cloud Kontext

Im Zusammenspiel mit der Google Cloud Platform (GCP) nutzt Terraform sogenannte „Provider“, um Ressourcen wie BigQuery-Datasets, IAM-Rollen, Service-Accounts, Transfer-Jobs oder Looker Studio Integrationen automatisiert bereitzustellen.

Vorteile:

- Automatisierung: Setup und Änderungen erfolgen über

terraform apply, wodurch Fehlerquellen reduziert werden. - Versionierung: Alle Konfigurationen sind in Git versionierbar und nachvollziehbar.

- Modularität: Infrastruktur lässt sich in wiederverwendbare Module strukturieren (z. B. ein Modul pro Kunde).

- Konsistenz: Alle Kundeninstanzen basieren auf derselben definierten Struktur.

- Skalierbarkeit: Neue Kunden können mit einem einzigen Befehl konfiguriert werden – mit definierter Datenquelle, Location, Zeitzone und Dashboard-ID.

Terraform Beispielkonfiguration:

Diese Beispielkonfiguration demonstriert, wie man mit Terraform zentrale Google Cloud-Ressourcen für ein Search Console-Dashboard-Projekt automatisiert anlegt. Im Fokus stehen die Aktivierung des BigQuery-Dienstes sowie die Vergabe von Berechtigungen an einen Service-Account, der beispielsweise Daten aus der Google Search Console importieren soll. Alle Einstellungen sind als Code definiert und können damit versioniert, dokumentiert und automatisiert ausgerollt werden.

variable "project_id" {

description = "Die ID Ihres Google Cloud Projekts"

type = string

}

variable "region" {

description = "Datenstandort / Ausführungsstandort"

type = string

default = "europe-west-3"

}

provider "google-beta" {

project = var.project_id

region = var.region

}

resource "google_project_service" "bigquery"

project = var.project_id

service = "bigquery.googleapis.com"

disable_on_destroy = false

}

resource "google_project_iam_member" "search_console_job_user" {

project = var.project_id

role = "roles/bigquery.jobUser"

member = "serviceAccount:[email protected]"

}

resource "google_project_iam_member" "search_console_data_editor" {

project = var.project_id

role = "roles/bigquery.dataEditor"

member = "serviceAccount:[email protected]"

}

Terraform Befehle im Überblick:

terraform apply -var-file='my-var-file.tfvars' -auto-approve // Wendet die Konfiguration an (ohne Rückfrage) terraform plan // Zeigt geplante Änderungen an terraform destroy // Löscht alle verwalteten Ressourcen terraform workspace new myproject // Erstellt einen neuen Workspace namens "myproject" terraform workspace select // Wechselt zwischen bestehenden Workspaces

Beispiel: Kunden-Dashboard automatisiert anlegen

In diesem Beispiel wird gezeigt, wie du mithilfe von Terraform ein vollständiges Kunden-Dashboard in der Google Cloud automatisch bereitstellst. Die Konfiguration erfolgt über eine separate .tfvars-Datei, in der alle kundenspezifischen Parameter zentral gepflegt werden. Das ermöglicht es, neue Kunden innerhalb weniger Minuten mit konsistenten Datenstrukturen und Dashboards auszustatten – ganz ohne manuelles Klicken in der Google Cloud Console.

Die Datei terraform.tfvars enthält u. a. folgende Parameter:

{

customer_name = "haarersatz24" // Eindeutiger Name oder Kürzel des Kunden

gitCommitish = "9264d79b859fa091235cd2c58b4c14a9462b79b28" // Version der Dataform-Transformation

defaultDatabase = "my_project_name" // Ziel-Dataset in BigQuery

defaultLocation = "europe-west3" // Region des Datasets (z. B. Frankfurt)

timezone = "Europe/Berlin" // Zeitzone für zeitbasierte Auswertungen

lookback = "30" // Rückblickzeitraum in Tagen für Datenabrufe

dashboard_id = "12398123-asdkjfb1239-1234bj-askjib" // Referenz auf ein Looker Studio Template

}

Mit diesem Setup erzeugt terraform apply automatisch alle relevanten Cloud-Ressourcen für den Kunden:

- ein BigQuery-Dataset mit der richtigen Location

- passende Berechtigungen

- Dataform-Jobs zur Transformation der Daten

- Verknüpfung zum Dashboard-Template in Looker Studio

Durch diese Automatisierung kannst du nicht nur Zeit sparen, sondern auch die Konsistenz und Wartbarkeit deiner SEA-Dashboards deutlich erhöhen. Die Konfiguration ist versionierbar, überprüfbar und lässt sich in CI/CD-Prozesse einbinden.

Der Weg zum Kunden-Dashboard

- Google Cloud Setup erstellen: Die nötigen Ressourcen wie BigQuery-Dataset, Service Accounts und IAM-Rollen werden mit Terraform definiert und ausgerollt.

- Dashboard-Vorlage erstellen: In Looker Studio wird ein generisches Dashboard mit Platzhalter-Datenquellen konzipiert, das später geklont wird.

- Kundenspezifische Konfiguration anlegen: Mittels

.tfvars-Dateien wird pro Kunde die Zielstruktur festgelegt (z. B. Dataset-Name, Zeitzone, Dashboard-ID). - Dashboards automatisiert erstellen: Mit Hilfe des Looker Studio Cloners (lsd-cloner) wird für jeden Kunden ein individuelles Dashboard aus der Vorlage erzeugt.

- Dashboard ausliefern & erklären: Die Dashboards werden an Kunden übergeben, erklärt und in die laufende Betreuung integriert.

- Optimieren & erweitern: Regelmäßige Anpassung der Dashboards an neue KPIs, Datenquellen oder Geschäftsmodelle halten die Reports aktuell und nützlich.

Weiterführende Links für detaillierte Anleitungen

Dieser Artikel fasst alle zentralen Aspekte des Vortrags auf dem SEACAMP 2025 zusammen und bietet eine praxisnahe Anleitung für den Aufbau skalierbarer SEA-Dashboards mit Google- und Microsoft-Daten. Von den Grundlagen der Dashboards über die Integration mit Looker Studio, BigQuery und Dataform bis hin zur automatisierten Infrastrukturverwaltung mit Terraform wurde Schritt für Schritt erläutert, wie eine professionelle Reporting-Architektur realisiert werden kann. Auch Tools wie der Looker Studio Dashboard Cloner (lsd-cloner) wurden praxisnah erklärt und in einen vollständigen Setup-Prozess eingeordnet. Ergänzt wird der Artikel durch weiterführende Links und Anleitungen zur Google Search Console, Matomo-Integration sowie Tipps zur Automatisierung. Damit bietet dieser Beitrag eine kompakte, aber tiefgehende Ressource für SEA-Profis, die Reporting nicht nur besser, sondern auch effizienter gestalten möchten.